Ilya Sutskever:我們正從規模法則時代邁入研究時代

開場:慢速起飛的錯覺

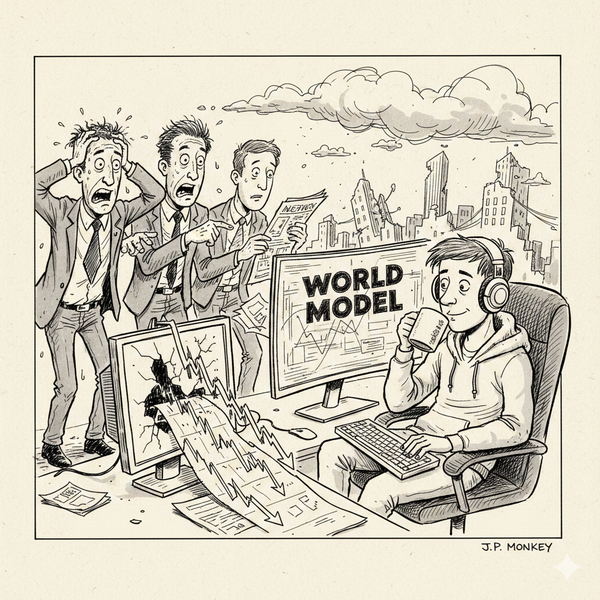

「你知道什麼最瘋狂嗎?就是這一切感覺有多麼『正常』。」

在 Dwarkesh Patel 的訪談中,Ilya Sutskever 說出了這句耐人尋味的話。

這確實是一個充滿矛盾的時刻。一方面,新聞標題充斥著數百億美元的 AI 投資、GPU 的搶購熱潮,以及對 AGI 即將毀滅(或拯救)世界的預言;另一方面,我們的日常生活似乎並沒有發生翻天覆地的變化。Siri 依然聽不懂複雜指令,Copilot 偶爾還是會寫出充滿 Bug 的程式碼,而我們依然要每天上班、吃飯、睡覺。

這種「雷聲大雨點小」的體感,讓許多人開始懷疑:我們是否正處於一個巨大的泡沫之中?

Ilya 的回答是否定的。他認為,我們感受到的這種「正常」,正是「慢速起飛(Slow Takeoff)」的特徵。這不是泡沫的破滅,而是我們正處於一個時代的交界點——我們正在從單純堆砌算力的「擴展時代(Age of Scaling)」,走向需要更深層智慧的「新研究時代(New Age of Research)」。

這篇文章將深入解析 Ilya Sutskever 的最新觀點,探討為什麼單純的擴展定律(Scaling Laws)可能已經不足以通往 AGI,以及人類大腦中那個尚未被破解的「演算法」,為何才是未來的關鍵。

第一轉折:擴展時代的終結與回歸

要理解為什麼現在需要尋找「新演算法」,我們必須看懂 AI 發展的歷史週期。Ilya 將其劃分為三個階段,這為我們判斷當前局勢提供了極佳的座標系。

2012-2020:研究時代(Age of Research)

從 AlexNet 的驚艷亮相到 GPT-3 的誕生前夕,這是百花齊放的時期。科學家們在黑暗中摸索,嘗試各種架構(CNN, RNN, LSTM),試圖證明深度學習的可行性。這是一個充滿不確定性,但也充滿創新的階段。

2020-2025:擴展時代(Age of Scaling)

這是我們剛剛經歷的黃金五年。擴展定律(Scaling Laws)成為了統治一切的定律。大家發現了一個簡單粗暴但極其有效的公式:更多數據 + 更多算力 = 更強模型。

這是一個「低風險投資」的時期。只要你有錢買 GPU,有辦法清洗數據,模型變強幾乎是物理定律般的必然。這也是為什麼微軟、Google、Meta 敢於投入數百億美元進行軍備競賽的原因,因為回報是可預期的。

2025+:新研究時代(The New Age of Research)

然而,Ilya 敏銳地指出,這個時代正在結束。

「但現在算力已經變得如此龐大……在某種意義上,我們又回到了研究時代。」

為什麼?因為「低垂的果實」快被摘光了。

- 數據枯竭:高品質的網際網路文本幾乎已被窮盡。

- 邊際效應:單純增加算力帶來的性能提升,開始遭遇邊際效應遞減。

預訓練(Pre-training)之所以強大,是因為它「不挑食」。它的答案是「一切」——把所有數據都餵進去。但當「一切」都餵完了,下一步該怎麼辦?

現在,我們回到了研究時代。只是這一次,我們手握前所未有的巨大算力。誰能率先發明出利用這些算力的新範式(例如高效的強化學習擴展(RL Scaling)、新的架構),誰就能開啟下一個時代。這正是 Ilya 創立 SSI 的技術動機。

核心深探:人類學習的奧秘(The Human Advantage)

如果說擴展定律(Scaling Laws)是過去幾年 AI 發展的聖經,那麼 Ilya 在這次訪談中,或許正在暗示這本聖經的「舊約」章節即將結束,而我們需要尋找「新約」。

這一切的線索,藏在他對人類與 AI 學習效率的深刻對比中。

數據效率的巨大鴻溝

我們常驚嘆於 GPT-4 閱讀了整個網際網路的知識,但 Ilya 提出了一個反直覺的質疑:為什麼它需要看這麼多?

試想一下,一個人類小孩學會開車、學會社交、甚至學會寫程式,需要閱讀幾兆個詞元的數據嗎?完全不需要。人類僅憑極少量的數據(Sample Efficient),就能掌握極其複雜的技能,並且具備強大的泛化能力(Generalization)。

相比之下,目前的 LLM 雖然強大,但本質上是「數據飢渴」的。它們需要看過幾乎所有變體,才能學會一個概念。這種巨大的效率落差,暗示了目前的 AI 架構可能還缺少了某種核心拼圖。

演化先驗 vs. 更強的演算法

通常有一種解釋是:人類之所以學得快,是因為演化在我們的大腦中預埋了大量的先驗知識。就像松鼠天生會跳躍,我們天生會語言。

但 Ilya 反駁了這個觀點。他舉了一個極具說服力的例子:寫程式(Coding)。

寫程式是人類歷史上最近幾十年才出現的技能,演化根本來不及為此在基因裡寫入任何先驗知識(Prior)。然而,人類工程師依然能憑藉有限的學習,寫出複雜且邏輯嚴密的程式碼。如果演化沒有幫忙,那解釋只有一個:

「這更表明,人類單純就是擁有更好的機器學習演算法。」

這句話是整場訪談的技術核心。它意味著,AGI 的關鍵可能不在於餵養更多的數據(因為數據快沒了),而在於破解大腦中那個「更好的演算法」。

尋找失落的演算法

那麼,這個演算法長什麼樣?Ilya 提到了兩個關鍵詞:非監督(Unsupervised) 與 內在價值函數(Internal Value Function)。

青少年學開車時,並沒有一個教練每毫秒都給他獎勵或懲罰,現實世界也不會像遊戲一樣即時顯示分數。但人類能通過觀察、預測和內在的自我修正,在極短時間內掌握這項技能。

這暗示了未來的 AI 研究方向,將從單純的「預訓練」轉向更像人類的學習方式——具備強大內在動機和自我監督能力的系統。這也是為什麼 Ilya 認為我們正在離開單純的擴展時代,回歸到需要發明新架構的研究時代。

SSI 的戰略:不參與老鼠賽跑

基於上述的洞察,Ilya 的新公司 SSI(Safe Superintelligence)制定了一套與眾不同的戰略。

為什麼要成立 SSI?

Ilya 直言,現在的 AI 領域是「公司多於想法」。

大多數公司都在同一條擴展的賽道上狂奔,爭奪同樣的 GPU,訓練類似的模型,發布類似的產品。這是一場典型的「老鼠賽跑」。

SSI 選擇退出這場遊戲。他們不發布產品,不爭奪短期營收,而是專注於最核心的「研究」。因為 Ilya 相信,如果上述的「人類學習演算法」被破解,現在所有的護城河都將失效。這是一場賭上未來的豪賭,賭的是誰能率先找到通往 AGI 的正確路徑。

安全即戰略:關愛感知生命

除了技術路徑,SSI 在安全策略上也提出了獨特的觀點。

Ilya 承認,他改變了想法。過去他可能認為「直通模式(Straight shot)」——在實驗室裡秘密造出 AGI 然後一次性發布——是可行的。但現在,他認為「漸進式發布(Gradual release)」才是必要的。

為什麼?因為人類社會需要時間來適應。我們需要讓世界「看見」AI 的強大,經歷衝擊、適應、然後學會與之共存。這是一個社會工程的過程,而不僅僅是技術問題。

更引人深思的是他對「對齊(Alignment)」的新定義。他不再強調讓 AI 遵守死板的規則,而是提出要讓 AI 「關愛感知生命(Care for sentient life)」。

這聽起來很抽象,但 Ilya 用演化論做了一個精彩的類比:基因本身是沒有智慧的,它的目標只是複製。但為了更好地複製,基因演化出了人類的大腦。而這個大腦,竟然發展出了「在乎他人看法」、「追求社會地位」這些與基因複製目標不完全一致、甚至更高層次的概念。

這證明了,一個低層次的最佳化過程(演化),是有可能湧現出具備高層次道德與情感的智慧體的。如果我們能正確設計 AI 的「基因」(基礎目標函數),或許真的能讓超級智慧演化出對人類的「關愛」。

長期的均衡

在這場訪談的最後,Ilya 展現了一種科學家的樂觀與冷靜。

他預測,雖然現在各家公司的路徑不同,但最終大家都會發現那條「正確的路」。技術路徑會收斂,安全策略也會收斂。未來不會只有一個統治一切的 AI 之神,而是會形成一個充滿各種專精 AI 的生態系,達到某種長期的均衡。

對於身處這個時代的我們來說,Ilya 的觀點是一個重要的提醒:不要被眼前的泡沫和喧囂迷惑。

當所有人都在關注下一批 H100 什麼時候到貨時,真正的變革可能正在某個安靜的實驗室裡發生。我們正從粗放的算力堆疊,轉向對智慧本質的精細探索。這不是 AI 的終點,甚至不是中點,這只是這場漫長馬拉松的熱身結束,正式比賽才剛剛開始。

敬請免費訂閱、贊助本電子報

Mosky 從零開始 AI 寫程式

折扣碼:FOXAI

課程連結和限時優惠網址:https://pse.is/8dqy89

折扣金額:$250

引用來源

- Dwarkesh Patel Interview with Ilya Sutskever (2024)