NVIDIA 自駕野心解析:Musk 潑冷水「達到 99% 很容易,長尾超級難」

黃仁勳的宣言

2026 年 1 月 6 日,黃仁勳站在拉斯維加斯 CES 的舞台上,對著台下超過六千名觀眾說出一句話:「物理 AI 的 ChatGPT 時刻來了,機器開始能夠理解、推理,並在真實世界中行動。」

這句話的重量不輕。兩年前 ChatGPT 橫空出世,改變了人們對語言 AI 的想像,現在黃仁勳把同樣的期待放到了自動駕駛上。他發布的產品叫做 Alpamayo,這是一個開源的自動駕駛 AI 模型家族,號稱能讓車輛「像人類一樣思考」。

首款搭載 Alpamayo 完整技術堆疊的量產車是 Mercedes-Benz 的 2025 年款 CLA,預計今年在美國上路。NVIDIA 的汽車業務預計在 2026 財年達到 50 億美元營收,黃仁勳直言:「自動駕駛革命已經到來,汽車將成為最大的 AI 與機器人產業之一。」

但這真的是自動駕駛的 ChatGPT 時刻嗎?要回答這個問題,得先理解 Alpamayo 到底在做什麼。

什麼是 Alpamayo?

Alpamayo 是 NVIDIA 發布的一系列開源 AI 模型、模擬工具與資料集,核心產品是 Alpamayo 1,這是一個 100 億參數的視覺-語言-動作模型(Vision-Language-Action Model,簡稱 VLA)。NVIDIA 已將 Alpamayo 1 的模型權重開放在 Hugging Face 上,任何人都可以下載使用,這是 NVIDIA 首次以完全開源的方式釋出自動駕駛核心模型。

傳統的自動駕駛系統採用模組化架構,感知、預測、規劃、控制各自獨立,資訊在模組之間傳遞時會有損失。近年來業界開始轉向端到端(end-to-end)架構,用單一神經網路直接從攝影機影像輸出駕駛軌跡,Tesla 的 FSD 就是這個路線的代表。

Alpamayo 走的也是端到端路線,但加入了一個關鍵元素:鏈式思考推理(Chain-of-Thought Reasoning)。

鏈式思考推理是什麼?

想像一個場景:你開車經過一個路口,前方有行人正在過馬路,旁邊有一台腳踏車,紅綠燈剛從綠轉黃。人類駕駛會在腦中快速推理:行人還沒走完,我應該減速;腳踏車可能會突然切入,要保持距離;黃燈了,來不及過,準備停車。

傳統的端到端模型是「黑盒子」,直接從影像輸出軌跡,中間的推理過程不可見。Alpamayo 的做法是讓模型把推理過程「說出來」,產生一段文字描述它看到什麼、判斷什麼、為什麼這樣決定,然後才輸出駕駛軌跡。

這種做法有幾個好處。第一,可解釋性提高,當車輛做出某個決策時,你可以看到它的推理過程,而不是只能接受黑盒子的輸出。第二,推理能力泛化,當遇到訓練資料中沒見過的場景時,模型可以用推理來填補經驗的空白,而不是直接失敗。

技術架構

Alpamayo 1 的架構分為幾個部分。多鏡頭影像和車輛運動資訊先經過視覺編碼器處理,產生視覺 token,這些 token 連同文字輸入一起送進 VLM 主幹網路(Cosmos-Reason),模型會自回歸地產生推理文字和離散軌跡 token。在推理階段,一個基於 flow matching 的動作解碼器會把離散軌跡 token 轉換成連續且符合車輛動力學的路徑點。

簡單來說,這個模型會先「想」一遍,把想法寫下來,然後才「動」。

NVIDIA 提出了三個關鍵創新。第一是因果鏈資料集(Chain of Causation Dataset),透過自動標註加上人工審核的方式,產生與駕駛決策因果連結的推理標註。第二是模組化 VLA 架構,結合 Cosmos-Reason 與擴散式軌跡解碼器,能即時產生動態可行的路徑規劃。第三是多階段訓練策略,先用監督式微調讓模型學會推理,再用強化學習優化推理品質。

根據 NVIDIA 發布的數據,Alpamayo 1 在困難場景的規劃準確度比純軌跡基線提升了 12%,偏離道路率降低 35%,近距離碰撞率降低 25%。

為什麼「長尾問題」這麼難?

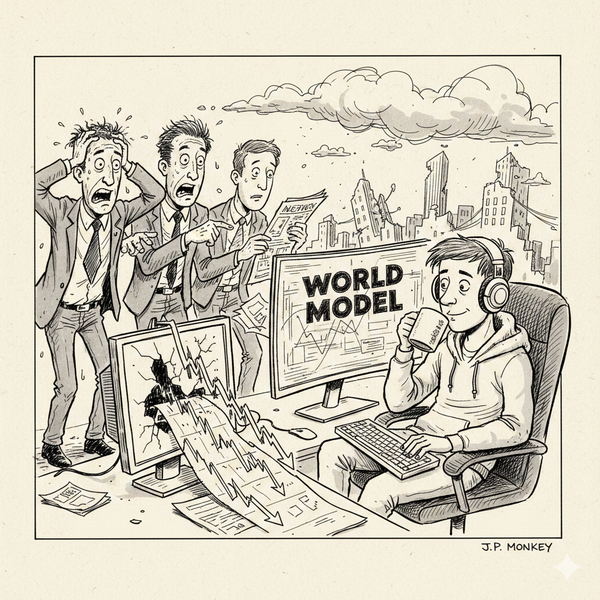

Elon Musk 在 X 上看到 NVIDIA 的發布後,留下一段評論:「他們會發現,達到 99% 很容易,但解決分布的長尾問題超級難。」他的 AI 負責人 Ashok Elluswamy 附和:「長尾太長了,大多數人無法理解。」

什麼是長尾問題?自動駕駛系統的訓練資料大多是「正常」的駕駛場景:直行、轉彎、停紅燈、讓行人,這些場景佔了 99% 以上,模型很容易學會。但真正致命的往往是那些罕見的邊緣案例:施工區的臨時標線、倒在路中間的樹、逆向行駛的腳踏車、突然衝出的動物。這些場景在訓練資料中極少出現,甚至從未出現,模型沒有足夠的經驗來處理,當遇到這些情況時,系統要不是直接失敗,就是做出危險的決策。

這就是長尾問題:常見情況很容易解決,但罕見情況的數量幾乎是無限的,而且每一個都可能致命。

Alpamayo 試圖用推理來解決這個問題。理論上,如果模型能夠理解因果關係,就能在遇到沒見過的場景時,用推理來推導出正確的行為。看到路中間有不明物體,推理它可能是障礙物,應該減速或繞開,而不是因為訓練資料中沒有類似案例就直接撞上去。

但 Musk 的質疑點在於:推理真的能解決長尾問題嗎?Tesla 已經累積了數十億英里的真實駕駛數據,他們的經驗是長尾問題幾乎是無窮無盡的,每解決一批邊緣案例,就會冒出新的一批。

說到底,兩家公司對問題本質的認知不同。NVIDIA 相信推理能力可以泛化,Tesla 相信只有海量數據才能覆蓋長尾。誰對誰錯,要等實際上路後才知道。

合作夥伴與落地時程

儘管有質疑,NVIDIA 的合作夥伴陣容相當驚人。這次 CES 2026 的重點是 Alpamayo 正式落地量產車。

Mercedes-Benz 是這次發布的核心。2025 年款 CLA 是首款搭載 NVIDIA DRIVE 完整技術堆疊的量產車,也是第一台整合 Alpamayo 推理能力的消費級車輛,獲得 2025 年歐洲 NCAP 最高安全評分。這台車具備 Level 2 進階輔助駕駛功能,支援點對點城市導航,預計今年底在美國實現免手駕駛。

NVIDIA 的汽車生態系還包括多家既有合作夥伴。Toyota 早在 2025 年 CES 就宣布加入 NVIDIA 陣營,全球最大的汽車製造商將在 NVIDIA DRIVE AGX Orin 上開發下一代車輛,運行經過安全認證的 NVIDIA DriveOS 作業系統。Aurora 與 Continental 的合作也源自去年,目標是 2027 年量產 Level 4 無人駕駛卡車,Aurora Driver 負責自動駕駛系統,Continental 負責量產製造,NVIDIA 提供運算平台。

其他合作夥伴還包括 JLR、Lucid、Uber,以及學術機構如 Berkeley DeepDrive。NVIDIA 把 Alpamayo 1 的模型權重完全開源,放在 Hugging Face 供任何人下載,希望透過開放生態加速整個產業的發展。

Musk 的態度:質疑但祝福

回到 Musk 的回應。他的完整評論是這樣的:「他們會發現,達到 99% 很容易,但解決分布的長尾問題超級難。我真心希望他們成功。」

這段話透露幾層意思:他認為 NVIDIA 的方向沒錯,但低估了問題的難度;他不認為 NVIDIA 是威脅,至少短期內不是;他樂見更多玩家投入自動駕駛,因為整個產業的進步對 Tesla 也有好處。

Tesla 和 NVIDIA 的路線差異在於數據。Tesla 有數百萬輛車在路上跑,每天產生海量真實駕駛數據,這是任何競爭對手都難以複製的優勢。NVIDIA 的優勢在於運算能力和開放生態,他們不自己造車,而是賣鏟子給淘金者。

兩條路線可能都會走向成功,也可能都會遇到瓶頸。自動駕駛的終局不會只有一個贏家,不同場景、不同市場可能需要不同的解決方案。

既是宣傳,也是願景

黃仁勳說「物理 AI 的 ChatGPT 時刻來了」,這句話既是宣傳,也是願景。ChatGPT 之所以成功,是因為它讓普通人能夠與 AI 對話,感受到 AI 的能力。自動駕駛要達到類似的「時刻」,需要讓普通人坐進車裡,放開方向盤,信任機器帶他們安全抵達目的地。

Alpamayo 是一個技術里程碑,鏈式思考推理為自動駕駛帶來了新的可能性。但從技術突破到大規模落地,中間還有很長的路要走。長尾問題不會因為一個新模型就消失,監管、保險、基礎設施都是待解的難題。

Mercedes-Benz CLA 今年在美國上路,這會是一個重要的測試。如果一切順利,我們可能真的站在自動駕駛普及的起點。如果出了問題,Musk 的話會被反覆引用:「達到 99% 很容易,長尾超級難。」

不管結果如何,2026 年的 CES 標誌著自動駕駛競賽進入了新階段。NVIDIA 把賭注押在推理能力上,Tesla 把賭注押在數據規模上,傳統車廠則在兩邊下注。最終誰會勝出,讓我們拭目以待。

相關資料:

-

NVIDIA Alpamayo 官方公告

https://nvidianews.nvidia.com/news/alpamayo-autonomous-vehicle-development -

NVIDIA CES 2026 發表會摘要

https://blogs.nvidia.com/blog/2026-ces-special-presentation/ -

Alpamayo 1 技術論文

https://arxiv.org/abs/2511.00088