Figure 機器人「快思慢想」的一小時物流處理影片

新創公司 Figure 推出的 Helix 模型,正將人形機器人的能力推向前所未有的高度,以下是他們推出的一小時影片,我覺得這很像是某種的 1 小時 ASMR 版影片 XDDD

Figure 將 Helix 定位為一種通用的「視覺-語言-行動」(Vision-Language-Action, VLA) 模型。它革新了機器人的感知、語言理解和運動控制方式,讓機器人能克服許多過去難以解決的挑戰。Helix 的出現,標誌著人形機器人在多個領域實現了重要的「第一次」突破:

- 控制全身、動作靈巧: Helix 是第一個能高速、連續控制整個人形機器人上半身 (包括手腕、軀幹、頭部、甚至獨立的手指) 的 VLA 模型。機器人不再只是僵硬的執行者,而是能做出更自然、細膩的動作。

- 聽懂人話,什麼都能撿: 配備 Helix 的 Figure 機器人,現在只要透過簡單的自然語言指令,就能撿起幾乎任何小型家庭物品。即使是數千種從未在訓練中見過的陌生物件,它也能理解指令並成功抓取。

- 不再單打獨鬥,學會合作: Helix 也是第一個能同時控制兩台機器人協同工作的 VLA 模型。兩台機器人能理解共同目標,分工合作,即使處理的是它們從未見過的新物品,也能透過語言指令完成複雜的協作任務。

- 一套模型搞定一切: Helix 最驚人之處在於,它使用單一套神經網路權重,就能學習並執行所有行為——從撿放物品、使用抽屜冰箱,到跨機器人互動,甚至應對多變的物流環境。無須針對特定任務額外微調,大大提高了效率和通用性。

- 硬體門檻降低,準備好商用: Helix 是第一個能在機器人本體搭載的嵌入式、低功耗顯示卡 (GPU) 上完整運行的 VLA 模型。這代表它在硬體需求上更親民,具備立即部署到實際商業應用的條件。

為何機器人難走出工廠,走入家庭?

過去,機器人主要活躍在嚴格控制的工業流水線,環境單純、任務重複,可靠性極高。但像家這樣充滿未知與變動的環境,卻是傳統機器人的噩夢。家裡有無數種物品,形狀、尺寸、材質各異,擺放位置隨機,光是要辨識和抓取就充滿挑戰。要讓機器人學會在這種環境中幫忙,傳統的方法——耗時費力的手動編程或需要上千次的人類示範——根本無法擴展應用到如此龐雜的任務種類。

Figure 認為,人工智慧領域在理解世界方面已經取得了巨大進步,特別是大型語言模型和視覺語言模型。這些模型從海量資料中學到了豐富的常識。如果能將這些「智慧」有效地轉化為機器人的「行動」能力,就能突破機器人泛化能力的瓶頸。Helix 的核心,正是要建立一套系統,能將高層次的語言指令和視覺理解,轉化為機器人精準細膩的動作。

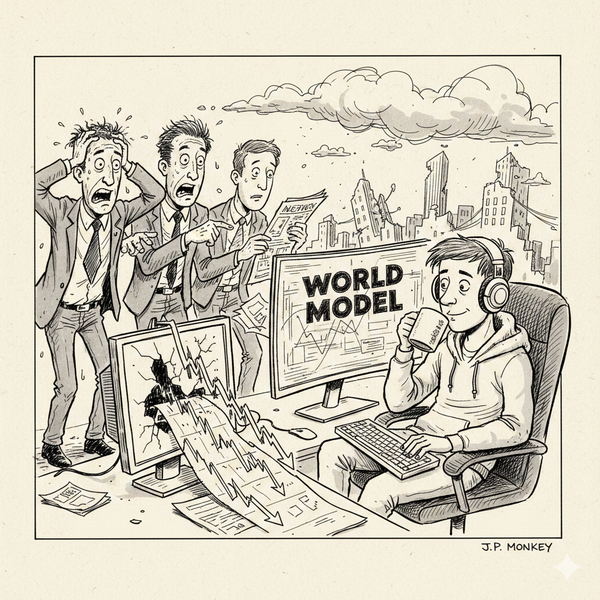

Helix 的「慢思考」與「快反應」大腦架構 (System 1, System 2)

Helix 的設計非常巧妙,它不是一個單一模型包辦所有事情,而是採用了類似人類大腦的「System 1, System 2」分工架構:

- 系統二 (S2): 這是機器人的「高層次大腦」,基於一個大型的視覺語言模型 (70 億參數)。它負責「慢思考」,接收機器人看到的影像和你的語言指令 (頻率約 7-9 Hz)。S2 的任務是理解整個場景的語義、判斷你的意圖、並規劃高層次的行動目標。它能辨識不同物品、理解抽象概念 (例如「甜點類物品」),並將這些理解轉化為一個緊湊的「潛在向量」,傳遞給負責執行動作的 S1。

- 系統一 (S1): 這是機器人的「低層次控制器」,一個較小的 Transformer 模型 (8000 萬參數)。它負責「快反應」,以高達 200 Hz 的頻率運行。S1 接收 S2 傳來的高層次意圖,結合當下的即時視覺和自身狀態感知,將其轉化為控制機器人全身關節的精準、連續動作指令。S1 能根據環境的細微變化,即時調整動作,確保流暢和穩定。

這種 S1/S2 分離的設計,讓每個系統都能在其最適合的速度運行:S2 可以花一點時間「想清楚」指令和場景,而 S1 則能以極快的速度「反應」並執行動作,確保了機器人既有高層次的理解能力,又不失即時控制的精準和穩定性。

將理想落地:物流場域的實證與能力再進化

Figure 不僅提出了 Helix 的架構,更將其部署到真實的物流環境進行測試,並在短短三個月內取得了顯著的進步。這也證明了 Helix 這種基於學習的方法,能快速將能力從訓練階段轉換到實際應用。

在這三個月的物流實測中,Helix 的表現大幅提升:

- 包裹處理能力進化: 它不再只能處理硬紙箱,現在連難以抓取的易變形塑膠袋、扁平信封等都能穩穩處理。針對不同材質和形狀,它能即時調整抓取策略 (例如輕拍壓平軟包裝以利掃描)。

- 速度與效率雙贏: 即使處理更複雜多樣的包裹,速度反而更快了!平均處理一個包裹的時間從約 5 秒縮短到 4.05 秒,效率提升約 20%,而且準確率更高。

- 條碼掃描成功率飆高: 透過更強的視覺感知和控制,將包裹翻轉至條碼朝下以便掃描的成功率,從約 70% 大幅提升至 95%。

- 學會應變的「小聰明」: 展現出從人類示範中學到的適應性行為,例如輕輕拍打軟包裝表面壓平皺褶,以確保條碼清晰。

能力飛躍的幕後推手:資料規模與模型精煉

這些在物流場域看到的具體進步,其原因正是 Helix 整體 VLA 框架的優化,特別是:

- 高品質訓練資料的擴充: 研究顯示,增加人類示範的訓練資料量,能直接提升 Helix 的處理速度和準確率。

- 模型架構的精煉: 在原有的 S1/S2 架構基礎上,Figure 為 Helix 導入了關鍵的感測與記憶模組,讓 S1 控制器更強大:

- 視覺記憶 (Vision Memory): 讓機器人能記住過去幾幀影像的資訊,幫助它建立對環境的「時間感」。它能記得包裹的哪一面看過、標籤曾在哪裡出現,減少重複動作,並規劃更複雜的多步驟操作 (例如多次微調包裹角度來找條碼),這對條碼成功率的提升功不可沒。

- 狀態歷史 (State History): 將機器人自身過去的運動狀態納入考量,讓 S1 在高速控制時能保持動作的連貫性,對外在干擾反應更快,是提升處理速度的關鍵之一。

- 力回饋 (Force Feedback): 整合了觸覺感知。機器人能「感覺」到接觸物體的力道,並據此調整抓取或推動的力道和時機。這讓操作更精準穩定,能應對包裹重量、軟硬等差異。

這些精煉後的模組,讓 Helix 的 S1 控制器能更有效地利用 S2 傳來的高層次理解,並在實際操作中展現出驚人的靈活和穩定性。

通用模型的無限可能:從分揀到遞物

Helix 單一套模型的設計,也展現了其極高的通用性。除了核心的物流分揀任務,Figure 發現只要加入少量的示範影片,機器人就能學會新的互動模式。例如,透過觀看人類將包裹遞給機器人的示範,Helix 就能學會將伸出的手視為遞交物品的訊號,做出遞出包裹的反應,而非將其放在輸送帶上。這種自然、情境式的互動,證明了 Helix 的 VLA 模型能輕易擴展到各種不同的應用情境。

Figure 的 Helix 模型,透過創新的 S1/S2 架構、海量高品質訓練資料的累積,以及關鍵感知與記憶模組的整合,成功打造出第一個能聽懂人話、控制全身、進行複雜協作,並在真實、多變環境中展現驚人操作能力的 VLA 人形機器人模型。它在物流場域的快速進步,更是最好的實證。

Helix 不僅提高了人形機器人的靈活性和可靠性,更大大降低了部署和擴展新能力的門檻。這代表著人形機器人正加速從實驗室和工廠,邁向我們的日常生活,未來在家庭、服務業,甚至是更廣泛的未知領域,都有可能看到它們的身影。Figure 相信這只是個開始,期待未來能將 Helix 的能力和規模繼續擴大,真正實現人形機器人普及應用的願景。