黃仁勳的「三大平台轉移」:為什麼 NVIDIA 不認為 AI 是泡沫?

NVIDIA 2026 財年 Q3 財報公佈後,市場反應耐人尋味,營收 570 億美元,年增 62%,淨利 320 億美元,年增 65%,光看數字,這是一份完美的成績單。但華爾街的態度卻很微妙,股價盤後僅漲 4%。

市場在擔心什麼?AI 泡沫論再次浮上檯面,CSP (Cloud Service Provider) 的 2026 年預期資本支出已經達到 6000 億美元,比年初預估高出 2000 多億,這麼大規模的投資,真的能產生對應的回報嗎?

但如果你仔細聽完 CEO 黃仁勳在財報會議上的發言,會發現他根本不認為這是泡沫,他的論述很明確:「我們正經歷三場大規模平台轉移,而且是自摩爾定律誕生以來第一次同時發生。」這是不是在畫大餅?以下是這個黃爸這個說法背後的商業邏輯。

黃仁勳的「三大平台轉移」理論

黃仁勳把當前的市場動能拆成三個層次,每一層都有不同的驅動力,但全都指向 NVIDIA。

第一層:CPU 到 GPU 的加速運算轉移

這是最容易被忽略、卻最關鍵的一層。

摩爾定律放緩後,傳統 CPU 的效能提升已經跟不上需求,雲端服務商每年數千億美元的運算支出,包括資料處理、科學模擬、工程計算,這些原本跑在 CPU 上的工作負載,現在正大規模遷移到 NVIDIA 的 GPU 上。為什麼?因為 CPU 路線的「通縮效應」消失了。

以前每一代晶片效能翻倍、成本減半,現在這個趨勢停滯,雲端服務商要維持成本競爭力,必須換架構。NVIDIA 的 CUDA 生態系經過 20 年淬煉,是唯一成熟的替代方案。

這一層的支出,完全由現有現金流支撐,不需要賭未來。

第二層:傳統 ML 到生成式 AI 的轉移

黃仁勳舉了 Meta 的例子。

Meta 的廣告推薦系統原本用傳統機器學習,現在全面轉向生成式 AI,新模型叫 GEM (Generative Model),跑在大規模 GPU 叢集上。結果是什麼?Q2 財報顯示,Instagram 廣告轉換率提升超過 5%,Facebook 動態消息提升 3%,這直接轉化成營收成長。

對 Meta 來說,這是投資報酬率明確的營收引擎。搜尋、推薦系統、廣告投放、內容審核,這些超大規模網路服務的核心功能,全在經歷這場轉型,這是兆元級的營運支出轉移,而且回報立竿見影。

第三層:生成式 AI 到 Agentic AI 的轉移

這是最新的一層,也是成長最快的。

Agentic AI 指的是能「推理、規劃、使用工具」的 AI 系統,Cursor、Replit 這類程式碼助手,Harvey 法律助手,iDoc 放射科影像分析,Tesla FSD 和 Waymo 自駕系統,都屬於這一類。

OpenAI 每週活躍用戶達 8 億,企業客戶破 100 萬,Anthropic 年化營收從年初的 10 億美元跳到 70 億美元,這些數字的背後,是全新的應用類別正在爆發。

三層疊加的意義

黃仁勳的論點是:這三層不是互相取代,而是疊加,每一層都有獨立的商業邏輯,都需要大量運算,而且都只有 NVIDIA 能全吃。這就是他認為「AI 泡沫論」看錯問題的原因。

戰略佈局:從晶片商到生態系建築師

如果只看財報數字,你會覺得 NVIDIA 是一家賣晶片的公司,但黃仁勳這季度花了很多時間談投資和合作夥伴關係,這才是真正的戰略重點。

Anthropic:3500 億估值背後的生態系邏輯

11 月 18 日,NVIDIA 和 Microsoft 宣布合計投資 Anthropic 150 億美元 (NVIDIA 100 億、Microsoft 50 億),這筆交易把 Anthropic 估值推到 3500 億美元,比 9 月的 1830 億幾乎翻倍。但重點不是錢,重點是「Anthropic 第一次採用 NVIDIA 架構」。

在此之前,Anthropic 主要用 Google 的 TPU 和 AWS 的 Trainium,現在他們承諾採購 300 億美元的 Azure 運算容量,部署最多 1 百萬瓩 (1 GW) 的運算能力,全部跑在 NVIDIA 的 Grace Blackwell 和未來的 Vera Rubin 系統上。

更關鍵的是技術深度整合:NVIDIA 和 Anthropic 會共同最佳化 Claude 模型,確保在 CUDA 上跑出最佳效能,同時,NVIDIA 未來的架構設計也會針對 Anthropic 的工作負載調校。

這種雙向最佳化,是 ASIC (客製化晶片) 永遠做不到的。

ASIC 的問題在於:當模型架構演進 (比如從 Transformer 到 Mixture of Experts),硬體就過時了,NVIDIA 的通用架構配上深度軟體合作,可以持續演進。黃仁勳說得很白:「我們現在是唯一能跑『所有前緣 AI 模型』的平台,OpenAI、Anthropic、xAI、Gemini、Llama,全部都跑。」

沙烏地 HUMAIN:60 萬顆 GPU 的地緣政治意義

另一個重大宣布是和沙烏地阿拉伯 PIF (主權基金) 旗下的 HUMAIN 合作。

未來五年部署約 60 萬顆 NVIDIA GPU,建設總容量達 500 百萬瓩的 AI 資料中心,這個專案的第一階段,就是 18000 顆 GB300 Grace Blackwell 超級電腦,而且 Elon Musk 的 xAI 會是第一個客戶。這不只是訂單,是地緣政治佈局。

黃仁勳在財報會議上說:「美國要贏,必須贏得每一個開發者的支持,必須成為全球每一家商業公司的首選平台,包括中國。」

中國市場這一季讓 NVIDIA 失望,H20 (為符合美國出口管制設計的降規版晶片) 銷售大幅低於預期,營收僅約 5000 萬美元,CFO Colette Kress 直說:「大量採購訂單在本季沒有成形,因為地緣政治問題和中國市場競爭加劇。」

NVIDIA 的應對策略是:既然中國市場受阻,那就在全球其他地方建立更深的據點,沙烏地、日本 (與富士通合作 NVLink Fusion)、印度、歐洲主權 AI 專案,全面開花。

投資邏輯:生態系擴張,而非單純財務投資

這也解釋了為什麼 NVIDIA 願意花錢投資 OpenAI、Anthropic、xAI 這些頭部模型公司。

黃仁勳說:「這些投資代表的是夥伴關係,目的是擴大 NVIDIA CUDA AI 生態系,確保每一個模型都能在 NVIDIA 平台上以最佳效能執行。」與其說是財務投資,不如說是生態系擴張的戰略手段,而且還能拿到股權,分享這些「世代型公司」的成長。

財務分析:毛利率保衛戰

光鮮的營收數字背後,有一場不太為人知的成本戰爭。

Q3 毛利率 73.6%,符合預期,但 Colette 對 2027 財年的指引很謹慎:「輸入成本正在上升,但我們會努力維持毛利率在 mid-70s (75% 上下)。」這句話透露的資訊量很大。

成本壓力來源

NVIDIA 面臨的成本壓力主要來自兩方面:

- 記憶體成本上漲:高頻寬記憶體 (HBM) 是 AI 晶片的關鍵零組件,供應商就那幾家 (SK Hynix、Samsung、Micron),議價能力有限。

- 先進封裝成本:CoWoS (晶片堆疊封裝) 產能主要掌握在 TSMC 手上,這也是成本壓力來源。

應對策略一:提前鎖定供應鏈

黃仁勳說:「我們的供應鏈夥伴很早就知道我們的需求和預測,我們已經和他們協商、規劃很長時間。」

Q3 庫存季增 32%,供應承諾 (supply commitments) 季增 63%,這代表 NVIDIA 正在大量提前採購,鎖定未來幾季的供應和價格。「當我們下單時,供應商可以直接拿到銀行去融資,當我們做預測時,他們會認真對待,因為我們的資產負債表和信譽在那裡。」這是超大規模公司才有的談判籌碼。

應對策略二:每一代架構的效能跳躍

Hopper 世代,每百萬瓩資料中心的 NVIDIA 內容產值約 200-250 億美元,Blackwell (特別是 Grace Blackwell) 提升到 300 億以上,Rubin 下一代會更高。但重點不是絕對產值,而是「每一代都有 x factor 等級的效能提升」。

客戶的 TCO (Total Cost of Ownership) 每一代都大幅下降,最關鍵的 performance per watt (每瓦效能) 持續領先。黃仁勳說:「一座百萬瓩資料中心就是百萬瓩,你的每瓦效能直接決定營收,這不是暴力堆料能解決的,這是極致共同設計 (co-design) 的結果。」

具體數字:MLPerf 訓練測試中,Blackwell Ultra 的訓練速度是 Hopper 的 5 倍;推理測試中,GB200 對 DeepSeek-R1 模型的效能是 H200 的 10 倍,每 token 成本也是 1/10。這種世代跳躍,讓 NVIDIA 能夠消化成本上漲,同時維持客戶的經濟效益。

應對策略三:產品組合與週期時間最佳化

Colette 提到,毛利率提升來自「資料中心產品組合、週期時間改善、成本結構最佳化」。

具體來說:GB300 (不含 Grace CPU 的純 GPU 版本) 現在佔 Blackwell 營收的 2/3,取代了 GB200 (含 CPU 的完整系統),GB300 的毛利率更高,因為系統複雜度較低。同時,隨著出貨量放大,製造良率提升,週期時間縮短,攤提成本下降,這些都是規模化帶來的自然優勢。

NVIDIA 對毛利率的管理策略是:用提前採購和長期合約鎖定成本,用架構創新維持客戶價值,用產品組合和製程最佳化吸收剩餘壓力,目標是守住 mid-70s,而不是無止境擴張。這是成熟的財務思維。

最大風險:不是技術,是電力與地緣政治

如果要說 NVIDIA 面臨的最大風險,技術競爭反而不是最關鍵的。

中國市場的結構性逆風

H20 這一季的銷售遠低於預期,營收僅 5000 萬美元,Colette 說「大量採購訂單沒有成形」。

問題不只是出口管制,黃仁勳坦承:「我們很失望,因為目前的狀況讓我們無法向中國出貨更有競爭力的資料中心運算產品。」言下之意,H20 的效能太弱,打不過中國本土的替代方案 (如華為的 Ascend)。

但 NVIDIA 不打算放棄,黃仁勳說:「我們會持續與美中兩國政府溝通,持續倡議美國要有能力在全球競爭。」同時加碼中國以外的市場,形成「地緣多元化」策略。

電力瓶頸:百萬瓩級資料中心的現實挑戰

xAI 的 Colossus 2 是全球第一座百萬瓩級資料中心,AWS 和 HUMAIN 宣布的專案,規模高達 15 萬顆加速器,這些數字聽起來很震撼,但電力從哪裡來?

分析師 Timothy Arcuri 直接問:「最大的瓶頸是什麼?電力、融資,還是記憶體、晶圓產能?」

黃仁勳的回答很實在:「這些都是問題,而且都是限制,當你以我們的規模和速度成長,怎麼可能有任何事情是容易的?」但他強調,NVIDIA 已經在「供應鏈下游」建立夥伴關係,包括土地、電力、外殼 (資料中心建設)、融資,「這些都不容易,但都是可處理、可解決的事情,最重要的是做好規劃。」換句話說,電力是挑戰,但不是死結。

ASIC 威脅被高估

市場一直有人擔心,雲端服務商自己開發的 ASIC (如 Google TPU、AWS Trainium) 會侵蝕 NVIDIA 市場。

黃仁勳這次花了很長篇幅反駁這個論點。他列舉了「五件讓 NVIDIA 特別的事」:

-

我們加速所有三個轉移階段 (CPU→GPU、ML→GenAI、GenAI→Agentic),一個架構全包。

-

我們擅長 AI 的每個階段:預訓練、後訓練 (post-training)、推理,全部領先。特別是推理,「思考 (reasoning) 本來就很難,怎麼會容易?」

-

我們是唯一能跑所有 AI 模型的架構:前緣模型、開源模型、科學模型、生物模型、機器人模型,全部都跑。

-

我們無處不在:每一朵雲、每一個地端、機器人系統、邊緣裝置、PC,一個架構到處跑,開發者最愛這個。

-

我們有 offtake (下游需求):如果你是 CSP 或新創雲 (如 CoreWeave、Lambda),用 NVIDIA 的好處是生態系龐大,客戶自然會來。「用隨便一個 ASIC 建資料中心,offtake 從哪來?」

最後這點最致命。技術再好,沒有生態系,就沒有商業模式。

ASIC 可能在特定工作負載上更便宜,但客戶要的是「通用性、靈活性、生態系支持」。而且黃仁勳提到,CUDA 的向後相容性讓 NVIDIA GPU 的生命週期遠超競爭對手,「六年前出貨的 A100,今天還在滿載執行,因為軟體堆疊持續進化,大部分非 CUDA 的加速器,幾年後就過時了。」這就是 NVIDIA 的終極護城河:不是技術領先幾年,而是「生態系慣性」讓競爭對手幾乎不可能追上。

重新定義「AI 基礎建設」

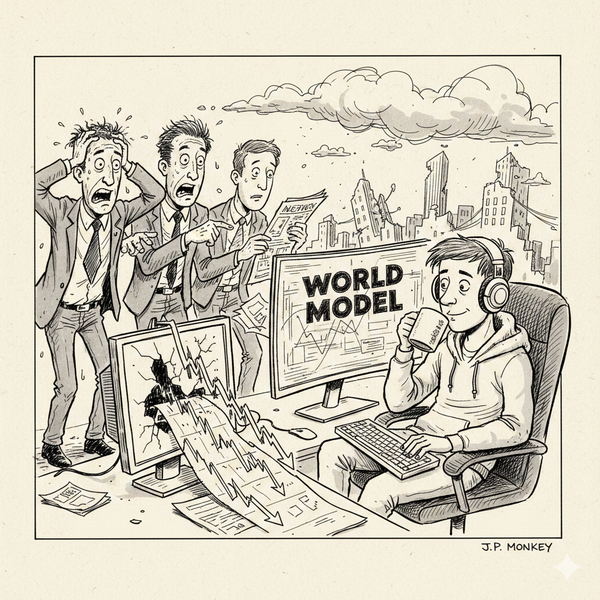

回到最初的問題:這是 AI 泡沫,還是結構性轉變?

如果你把 AI 基礎建設等同於「訓練大型語言模型」,那確實可能有泡沫風險,但黃仁勳的論述告訴我們,真實情況複雜得多:第一層 (CPU→GPU) 是防禦性支出,雲端服務商不做就會失去成本競爭力;第二層 (ML→GenAI) 是營收增強,Meta、Google 的廣告和推薦系統轉型,ROI 立竿見影;第三層 (GenAI→Agentic AI) 才是真正的「新應用」,而這一層正在爆發。三層疊加,每一層都有獨立的商業邏輯,每一層都需要大量運算,而且只有 NVIDIA 能全吃。

市場有多大?

NVIDIA 預計,到這個十年結束,全球每年 AI 基礎建設支出會達到 3-4 兆美元,目前 CSP 的 2026 年資本支出預估是 6000 億,只佔這個市場的一小部分。 NVIDIA 認為這是三場革命同時發生,而 NVIDIA 站在正中央。

資料來源:

- NVIDIA Q3 FY2026 Earnings Call Transcript (November 19, 2025)

- Microsoft, NVIDIA and Anthropic Strategic Partnership Announcement (November 18, 2025)

- HUMAIN and NVIDIA Strategic Partnership Announcement (November 19, 2025)