別怕被 AI 取代!放射科給所有知識工作者的啟示:你的價值藏在機器看不懂的地方

本文主要內容出自於 Deena Mousa 電子報,The Works in Progress Newsletter

「我們現在就該停止訓練放射科醫生」

這句鏗鏘有力的斷言,出自2016年人工智慧界的巨擘 Geoffrey Hinton 之口。當時,AI 的浪潮正席捲全球,而放射科影像判讀,一個高度依賴數位影像、具備明確基準與重複性任務的領域,被視為最快會被機器取代的人類專業。Hinton 的話語,宛如一紙對放射科醫生這門職業的末日預言,讓許多人相信,AI 將在短時間內接管所有影像判讀工作,人類專家的角色將迅速式微。

然而,將近十年過去,現實卻上演一齣截然不同的戲碼。不僅沒有出現放射科醫生的大規模失業潮,對他們的需求反而攀上前所未有的高峰。2025年,美國放射科住院醫生計畫提供創紀錄的1208個職位,職位空缺率亦達歷史新高。與此同時,放射科醫生的薪資水準一飛沖天,平均年收入高達52萬美元,相較於2015年,成長幅度超過48%,使其成為全美收入第二高的醫療專科。

這是一個巨大的悖論:在一個最適合被 AI 取代的領域,人類專家的價值為何不減反增?這場看似註定由機器獲勝的競賽,為何以人類的全面勝利暫告一段落?深入探究其背後的原因,我們發現,這並非單純的技術問題,而是一場涉及臨床現實、法律規範、人類行為與經濟動能的複雜博弈。

實驗室的王者,臨床的挑戰者

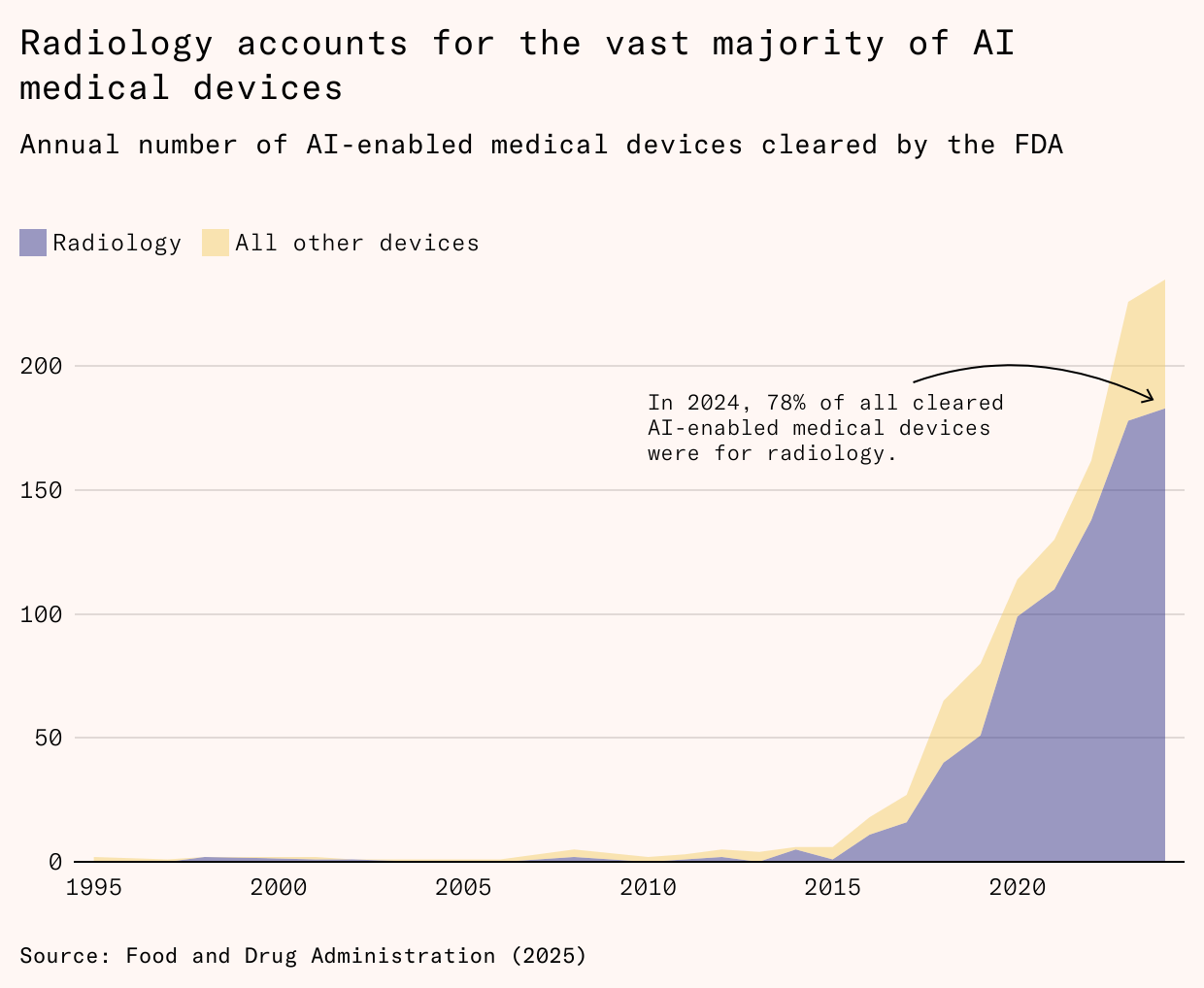

AI 在放射學領域的初登場確實驚艷四座。2017年問世的 AI 模型 CheXNet,在判讀胸部 X 光片的肺炎病徵時,其準確度已超越一組通過專業認證的放射科醫生。此後,各類型的 AI 產品如雨後春筍般湧現,它們能在基準測試中,以比人類更快的速度、更高的精度,偵測數百種不同掃描影像中的病灶。至今,美國食品藥物管理局(FDA)已核准超過700種放射學 AI 模型,佔所有醫療 AI 設備的四分之三。

這些模型在受控的基準測試中表現優異,但一旦進入真實、混亂的醫院環境,它們的完美光環便迅速褪色。這背後的第一層原因,在於「基準測試」與「臨床實踐」之間的巨大鴻溝。

AI 模型的訓練過程,宛如在無菌實驗室中培養植物。開發者會使用經過嚴格篩選的影像資料集,這些影像中的診斷必須明確無誤,通常由二至三位專家達成共識,或有病理結果作為最終確認。所有拍攝角度不佳、過於模糊或光線昏暗的影像都會被剔除。這種作法確保模型能學會辨識最典型、最清晰的病例,但也導致其性能偏向於醫生本來就最擅長診斷的「簡單個案」。

當 AI 面對真實世界的影像時,挑戰便接踵而來。一位放射科醫生描述:「我所使用的一款模型,會把手術釘標示為出血,只因為在影像中它們都呈現明亮的條紋。」真實的臨床影像充滿變數,疾病可能以非典型或極其細微的形式呈現,也可能同時存在多種相互干擾的病理狀況,例如肺積水或肺塌陷,這些都可能讓 AI 產生混淆。人類醫生能借助病患的完整病史與其他臨床資訊進行綜合判斷,但多數 AI 模型卻缺乏這種全局觀。

更嚴峻的挑戰是「樣本外」的性能衰退。在美國,38% 的 AI 模型在申請監管批准時,僅使用來自單一醫院的數據進行測試。當這些模型被部署到其他醫院時,由於不同醫院的病患族群、影像設備校準方式、甚至是技師的操作習慣都存在差異,其性能可能會大幅下降,降幅有時高達20個百分點。這意味著每家醫院在引進新的 AI 工具前,即便該工具已在別處證明有效,仍需耗費資源進行重新訓練或驗證,大幅增加其應用門檻。

數據偏見也是一個根深蒂固的問題。用於訓練的醫學影像資料集,往往缺乏來自兒童、女性及少數族裔的案例,這使得模型對這些族群的診斷表現普遍較差。許多數據集甚至根本沒有標註性別或種族資訊,讓修正這些偏見變得難上加難。

回顧歷史,這並非 AI 首次在臨床應用中遭遇挫敗。早在1990年代,一種被稱為「電腦輔助診斷」(CAD)的早期 AI 系統被開發用於篩檢乳房攝影,以尋找乳癌跡象。初步試驗顯示,人類醫生與 CAD 系統的組合,其判讀準確性高於單純的人類醫生。基於這些樂觀的結果,FDA 在1998年批准這項技術,聯邦醫療保險(Medicare)也從2001年開始提供給付。到了2010年,全美約74%的乳房攝影檢查都有 CAD 系統的參與。

然而,大規模的臨床研究揭示一個令人失望的真相。一項涵蓋43萬次檢查的大型研究發現,引進 CAD 的診所,雖然讓醫生多執行20%的切片檢查,但最終發現的癌症數量並未增加。換句話說,CAD 系統增加假警報的機率,導致更多不必要的侵入性檢查,卻沒有提升癌症的檢出率。另一項研究更指出,相較於由兩位醫生進行「雙重判讀」,CAD 的表現不僅更差,甚至還不如標準的單人判讀流程。最終,在2018年,Medicare 停止為使用 CAD 的乳房攝影提供額外給付。

這個歷史教訓凸顯人類行為在其中的關鍵角色。在受控的實驗環境中,醫生或許能理性地將 AI 的提示作為參考,但在日常高壓的臨床工作中,他們似乎會過度依賴 AI。一項2004年的研究發現,當 CAD 系統未能標示出惡性腫瘤時,許多醫生會將此視為影像乾淨的保證,從而錯失診斷機會。當 AI 提供錯誤指引時,醫生做出錯誤決策的可能性比未受輔助的同儕高出26%。

跨越技術之外的重重關卡

即便我們能開發出完美的 AI 模型,解決所有技術上的限制,它依然無法完全取代放射科醫生。因為影像判讀,僅僅是放射科醫生工作的一部分。

2012年一項針對三家醫院放射科醫生的研究發現,他們只有36%的時間用於直接的影像判讀。其餘大量的時間,則用於監督影像檢查的執行、與主治醫師溝通診斷結果與治療建議、直接與病患解釋病情、指導住院醫生與放射技師,以及審核影像檢查的申請與調整掃描參數。這些任務涉及複雜的溝通、決策、教學與品質控管,遠非當前 AI 的能力所及。AI 或許能加速判讀過程,但放射科醫生只需將節省下來的時間,轉移到其他無法被自動化的工作上。

法律與保險制度,則構成另一道難以逾越的高牆。FDA 將影像軟體分為兩類:「輔助或分流工具」與「自主診斷工具」。前者僅作為醫生的助手,最終報告仍需由執業醫師簽署;後者則可獨立運作。要成為自主診斷工具,AI 必須通過極其嚴格的審查,證明它能自動拒絕判讀任何品質不佳或超出其能力範圍的影像。這個門檻非常高,因為一旦人類監督的角色消失,軟體中一個潛在的缺陷,就可能在被發現前傷害成千上萬的病患。

即使有模型成功獲准自主運作,醫療疏失保險公司也對此抱持高度疑慮。診斷錯誤是美國醫療疏失賠償中最昂貴的一項,而放射科醫生是常年的被告。保險公司認為,單一演算法的錯誤可能同時影響大量病患,引發災難性的集體索賠,其風險遠高於單一醫生的偶發失誤。因此,許多保險合約中開始出現類似「絕對 AI 豁免」的條款,明確表示不為軟體自主生成的診斷提供任何保障。

在缺乏保險覆蓋的情況下,醫院幾乎不可能冒著巨大的財務風險,讓演算法獨立簽署診斷報告。除非醫院相信自主 AI 帶來的成本節省或效率提升,足以抵銷這些龐大的法律與制度性風險,否則「人機協作」仍是唯一可行的模式。

需求彈性下的經濟反饋

最後,一個看似違反直覺的經濟學現象,為放射科醫生需求的增長提供最終的解釋,傑文斯悖論(Jevons paradox)。這個理論指出,當一項技術的進步提升資源使用的效率時,反而可能導致該資源的總消耗量增加。

這個現象在放射學領域早有先例。2000年代初期,醫院從傳統的膠片影像全面轉向數位化系統。數位化大幅提升放射科醫生的工作效率,判讀單張影像的時間顯著縮短。溫哥華綜合醫院的一項研究顯示,改用數位系統後一年內,放射科醫生在普通放射攝影的效率提升27%,在電腦斷層掃描(CT)的效率更是飆升98%。

按照傳統邏輯,效率的提升應當意味著所需人力減少。但事實上,沒有放射科醫生因此被解雇。相反地,從2000年到2008年,美國每千名被保險人的影像檢查總使用率,暴增60%。原因在於,數位化不僅讓判讀變快,也大幅縮短報告的周轉時間。過去,急診病患的 X 光報告中位數等待時間長達76小時,數位化後降至38小時。

影像檢查的「時間成本」大幅降低,促使臨床醫生更頻繁地使用這項工具。過去只有在極端創傷情況下才會考慮的全身 CT 掃描,如今因其快速的周轉時間而成為常規選項。影像檢查的需求呈現高度彈性,當其價格(無論是金錢或時間)下降時,需求量便不成比例地大幅增加。

AI 的導入,正複製這段歷史。AI 進一步壓縮判讀時間,降低成本,這可能誘發新一輪的影像檢查需求增長。更多的檢查量,意味著需要更多的放射科醫生來執行那佔據他們64%工時的、無法自動化的任務。

過去十年的發展,揭示一個深刻的啟示:AI 在放射學領域的應用,其前景被單純的基準測試過度誇大。從實驗室到臨床的道路上,充滿技術的侷限、人類行為的變數、制度的慣性以及經濟力量的反饋。每一個環節都讓「完全取代」成為昂貴且充滿風險的選項,而「人機協作」則成為預設的路徑。

放射學的故事,為我們理解 AI 如何融入複雜的知識型工作提供一個寶貴的模型。在那些任務多元、風險高昂、需求富有彈性的領域,軟體的進步,至少在初期階段,帶來的或許不是工作的終結,而是更多的人類參與。機器越是精進,放射科醫生反而越是忙碌,這個弔詭的現象,至今依然成立。